“Tudo o que preciso é de um arquivo do QuickTime.” Quantas vezes você ouviu isso de um cliente? Infelizmente, isso não é informação suficiente. Aqui estão as razões do porquê.

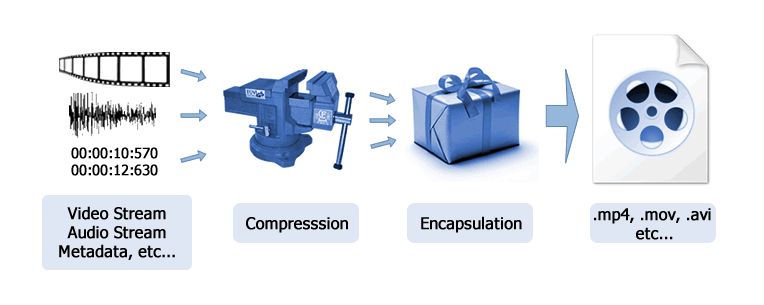

Os arquivos digitais consistem em contêineres de formato, dados e metadados. Um wrapper de formato define o tipo de arquivo, conforme identificado pela extensão, como .mpeg, .mov, .mp4, .mxf, etc. Pense em um wrapper como uma fita de fita de vídeo. Ele marca qual aplicativo do player deve ser compatível com esse arquivo, assim como uma fita VHS mostrava que era necessário um player VHS. Os dados são o conteúdo de áudio / vídeo contido nesse wrapper de formato. Os metadados são informações sobre esses dados, como carimbos de data / hora, perfis de cores e muito mais.

COMPREENDENDO

Sinais de áudio e vídeo são codificados em arquivos digitais usando codecs – abreviação de compressão / descompressão. A maioria dos arquivos de vídeo usa compactação de dados, enquanto o sinal de áudio em formatos profissionais normalmente não é compactado. Por outro lado, os formatos de áudio do consumidor, como .mp3 e .m4a, usam um codec altamente compactado. Embora tendamos a associar certos codecs a formatos específicos, como ProRes e .mov, eles não são sinônimos. Por exemplo, os arquivos podem ser codificados com o codec ProRes e armazenados em wrappers .mxf.

A compactação de vídeo é definida como com ou sem perda visual. Isso é determinado pelo tipo de codec, taxa de dados usada para codificar o arquivo, taxa de quadros e tamanho do quadro. O tamanho dos arquivos será menor quando um método com perdas for usado. Porém, eles exibirão artefatos de compressão visíveis aos olhos, porque muitas informações de sinal são jogadas fora. Serviços de streaming como Netflix e YouTube usam métodos com perdas para obter o sinal para sua casa pela Internet. Codecs sem perda visual, como versões de alta taxa de bits do Avid DNx ou da família de codecs Apple ProRes, são usados na aquisição e pós-produção de câmeras. Esses codecs empregam uma alta taxa de dados para compactação e terão tamanhos de arquivo significativamente maiores. No entanto, os artefatos de compactação são geralmente indiscerníveis aos olhos em comparação com o vídeo não compactado.

A grande maioria dos codecs usados na produção e publicação atualmente são de propriedade intelectual de empresas ou associações. Eles não são de código aberto ou padrão aberto, mesmo que seu uso possa ser onipresente. O uso de um codec, especialmente para codificar dados para esse codec, requer um contrato de licença. Normalmente, isso é transparente e parece gratuito para o usuário, mas tenha certeza de que foi feito um acordo entre as empresas. Como em toda propriedade intelectual, isso pode resultar em um codec não estar mais disponível em um aplicativo se esse acordo terminar entre as empresas.

COMPONENTES DE BIBLIOTECA E TRANSIÇÃO PARA 64 BITS

Quando um arquivo de vídeo é reproduzido por um aplicativo, seus dados são decodificados on-the-fly e exibidos como pixels RGB na tela ou em um visualizador na interface. Isso requer um conjunto de componentes de biblioteca instalados que o aplicativo utiliza para ler, decodificar e exibir os dados do vídeo. Esses componentes podem fazer parte do sistema operacional do computador ou são componentes instalados personalizados que funcionam apenas para esse aplicativo.

Com o tempo, a Apple e a Microsoft abandonaram ou “preteriram” o suporte a codecs mais antigos em seus próprios sistemas operacionais. Por exemplo, o Catalina da Apple é um sistema operacional de 64 bits, sem suporte para aplicativos de 32 bits e componentes de biblioteca. Isso significa que determinados codecs – incluindo muitos ainda em uso ativo, como DNxHD / HR – não podem mais ser decodificados (reproduzidos) por qualquer aplicativo que dependa da estrutura QuickTime de 32 bits usada nas versões anteriores do macOS. Este não é um problema do codec em si, mas dos componentes da biblioteca usados.

Para que esses arquivos funcionem na Catalina, a Apple ou o desenvolvedor do aplicativo precisa escrever novos componentes da biblioteca de 64 bits para reproduzir esses arquivos daqui para frente. No caso do DNx, a Avid e a Adobe podem ler e gravar esses arquivos no formato .mxf, mas os aplicativos da Apple, como o Final Cut Pro X ou o QuickTime Player, não podem fazer o mesmo. Espere que seja atualizado ainda este ano.

POR QUE NÃO POSSO GRAVAR ARQUIVOS RAW DE CÂMERA NA PÓS?

As câmeras de vídeo digital convertem os dados brutos do sensor em informações de pixel RGB e gravam em um arquivo digital usando um codec e formato definidos. O processamento é feito na câmera para “incorporar” a conversão dos dados do sensor de padrão Bayer em RGB, junto com seu ISO nativo e um perfil de cores. Esses arquivos são facilmente reproduzidos pela maioria dos aplicativos profissionais de edição e reprodutor.

Desde o lançamento da câmera RED One do RED Digital Cinema, os codecs raw cresceram em popularidade. Quando você grava um sinal de câmera não processada, a etapa de conversão / processamento para RGB é ignorada, permitindo acesso a mais latitude para correção de cores na postagem. Também gera imagens de qualidade superior para uma taxa de dados e tamanho de arquivo equivalentes. A desvantagem é que os arquivos camera raw sobrecarregam os sistemas de hardware usados na postagem. Isso ocorre porque as conversões que teriam sido feitas na câmera agora são realizadas em tempo real pelo computador.

Codecs raw armazenam informações geradas pelo sensor da câmera e destinam-se apenas à aquisição de imagens. Você não pode gravar ou recodificar os arquivos raw da câmera na postagem, porque não há dados do sensor disponíveis. Os codecs de camera raw também são proprietários de empresas individuais, incluindo RED, ARRI, Apple, Blackmagic Design e outros. Por enquanto, não há vídeo equivalente ao CinemaDNG, um formato bruto para fotografia desenvolvido pela Adobe e oferecido como um padrão aberto à comunidade. Embora se possa argumentar que o codec CineForm RAW da GoPro é uma solução comparável para vídeo.

O vídeo de codecs não-raw pode ser ajustado através da correção de cores, mas na verdade você não está alterando o processamento de cores subjacente do próprio arquivo. Você está distorcendo as informações RGB que já estão lá. Por outro lado, os codecs de câmera raw oferecem a oportunidade de aproveitar a maneira como os dados do sensor são realmente decodificados, usando vários esquemas de ciência e ajuste de cores. Isso exige que cada empresa crie um plug-in camera raw específico para seu codec proprietário, que o usuário pode acessar para “desenvolver” a imagem. Os engenheiros de software têm várias opções: 1) manter esse processo proprietário isolado para seus próprios aplicativos, 2) criar plug-ins para uso de outras empresas, 3) criar componentes de SO nos quais todos possam acessar ou 4) oferecer um SDK e permitir que outros as empresas escrevem suas próprias ferramentas para usar em seus próprios aplicativos – geralmente concorrentes.

Codecs como o REDCODE são amplamente suportados na maioria dos aplicativos, graças aos plug-ins do RED. Outros, como o ProRes RAW e o Blackmagic RAW, estão em um estado de transição, já que os NLEs adicionam suporte no próximo ano. Em um sentido prático, se você possui uma câmera que grava vídeos brutos, não pense que sua ferramenta de edição favorita ou agência de pós-produção possa lidar com esses arquivos. Como sempre, faça sua lição de casa e faça as perguntas certas.

Artigo original extraído de https://www.tvtechnology.com/news/a-simple-guide-to-formats-and-codecs